Shakespear, l'entropie, et ChatGPT

J'explore actuellement les méthodes d'analyse de texte. C'est un domaine vaste, plus connu sous son nom anglais, Natural Language Processing (NLP).

Pendant mes recherches, je suis tombé sur un concept que je trouve particulièrement intéressant : l'entropie. Je vous en parle aujourd'hui.

L'entropie d'un texte

L'entropie vient de la théorie de l'information, où elle est utilisée pour mesurer l'incertitude ou la surprise associée à un ensemble de données. Lorsqu'on applique ce concept au texte, l'entropie mesure la diversité et la complexité du choix des mots.

Par exemple, une phrase simple comme "Le chat dort" a une faible entropie, car les mots sont prévisibles et peu diversifiés. En revanche, une phrase plus complexe comme "Le chat tigré, aux yeux verts perçants, se prélasse sur le canapé rouge en cuir" présente une entropie plus élevée, en raison de la diversité et de la richesse du vocabulaire utilisé.

Une entropie basse signifie que le texte est plus prévisible, avec moins de diversité dans le choix des mots. Cela peut se produire dans des textes répétitifs ou avec un vocabulaire plus simple et moins varié.

L'entropie donne une idée de la diversité des mots utilisés dans un texte, mais attention, elle ne préjuge pas de sa qualité. On mesure ici uniquement la densité d'information, au sens de la théorie de l'information, contenue dans un texte.

Trois grandes oeuvres aux entropies différentes

Pour illustrer notre propos, comparons l'entropie moyenne des phrases de quelques œuvres bien connues, avec des styles et objectifs différents :

- Candide de Voltaire

- Roméo et Juliette de William Shakespeare

- L'Origine des espèces de Charles Darwin

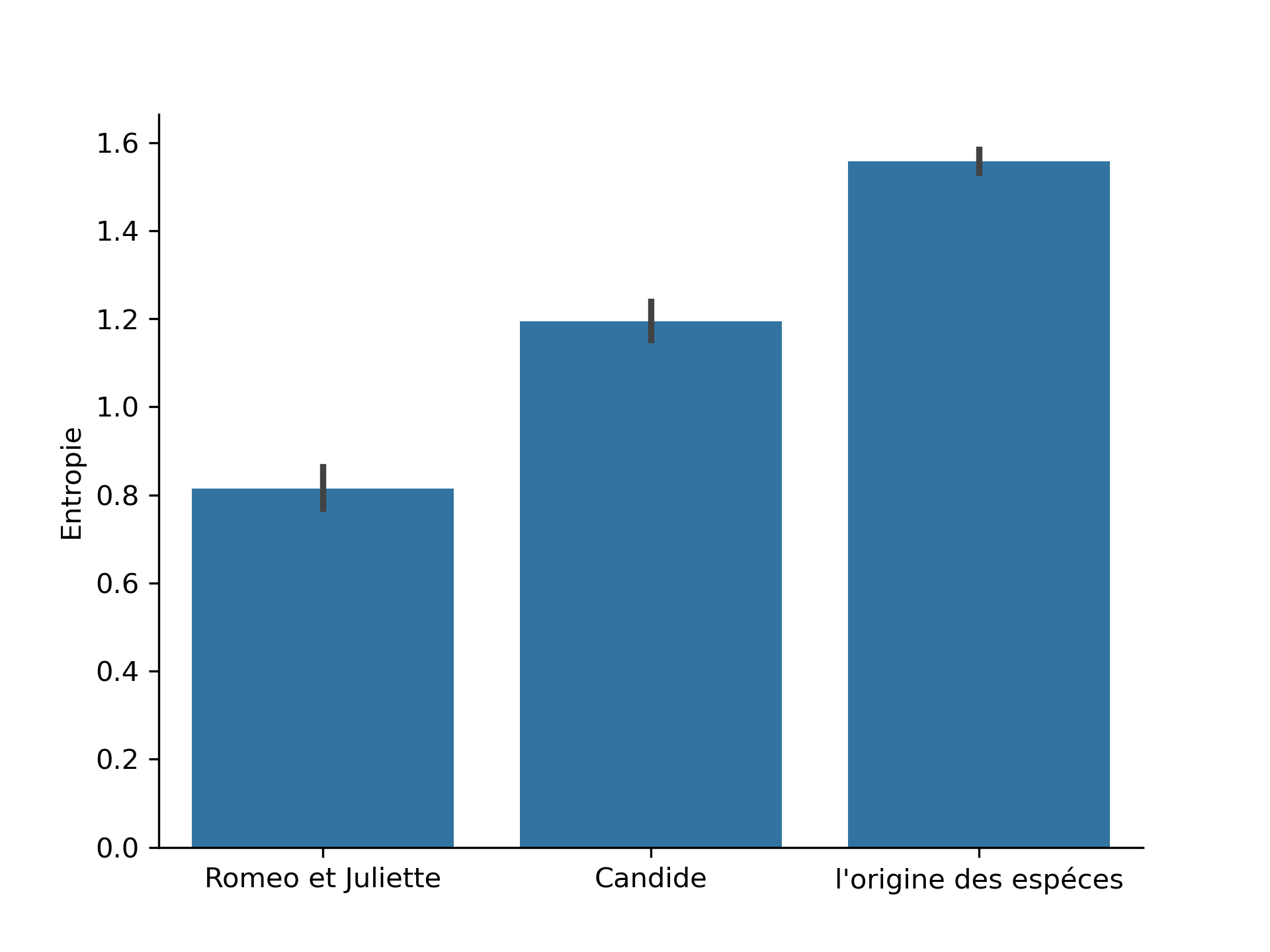

Voici un graphique montrant l'entropie moyenne par phrase pour chaque livre :

On voit que pour Roméo et Juliette, l'entropie moyenne est la plus basse des trois œuvres, autour de 0.8. On peut expliquer cela par la présence de dialogues récurrents entre les personnages principaux. De plus, les thémes principaux abordés sont restreints. L'oeuvre de Shakespear se concentre en effet surtout sur la famille et l'amour.

Pour Candide, l'entropie moyenne est modérée, environ 1,2. Le texte de Voltaire montre une plus grande variété dans le choix des mots et des structures de phrases. Cela est probablement dû à la multitude de lieux visités, de personnages rencontrés et de thèmes abordés par Candide et Pangloss.

Enfin, L'Origine des espèces a l'entropie moyenne la plus élevée des trois œuvres, autour de 1,6. L'œuvre scientifique de Darwin présente une grande diversité lexicale et des structures de phrases plus complexes. Il s'agit d'un texte scientifique détaillant des observations et des théories sur l'évolution, nécessitant l'utilisation de termes précis, variés et peu communs.

Comment capturer toutes les dimensions d'un texte

L'entropie offre un regard intéressant sur ces œuvres. Ces trois œuvres sont magistrales, mais elles le sont dans leur style propre, et l'entropie permet de résumer une petite part de ce style en un seul chiffre.

Bien entendu, la portée et la qualité des œuvres sont bien plus complexes que cela, mais cette mesure donne une idée de comment les styles de texte et de langage peuvent être analysés dans le traitement automatique du langage.

Il existe d'autres types de mesures pour capturer d'autres dimensions des textes. Voici par exemple une liste non-exhaustive :

- Fréquence des mots : Analyse combien de fois chaque mot apparaît dans un texte, permettant de détecter des termes clés et des sujets récurrents.

- Complexité syntaxique : Évalue la structure des phrases, en analysant la longueur des phrases, le nombre de clauses subordonnées, et la variété des structures grammaticales.

- Analyse des sentiments : Mesure les émotions véhiculées par le texte, en catégorisant les passages comme positifs, négatifs, ou neutres.

- Cohérence textuelle : Examine comment les idées et les thèmes sont reliés tout au long du texte, assurant une continuité et une logique dans l'argumentation.

- Densité sémantique : Évalue la richesse du contenu en termes de concepts et d'idées, mesurant la quantité d'informations nouvelles apportées par chaque mot ou phrase.

Les IA génératives

Ces mesures font partie des méthodes d'analyse automatique du langage. Ce sont des domaines proches des stars du moment : les IA génératives de langage, ou LLM (Large Language Models) dont fait partie ChatGPT. Avec tous ces concepts, les IA génératives sont capables d'adapter leur style en fonction de la situation ou de ce qui est demandé par l'utilisateur. Vous pouvez demander à ChatGPT d'écrire avec plus ou moins d'entropie, il interprète ça très bien.

La petite révolution qui est en train de s'opérer est que le langage n'est peut-être plus réservé uniquement à l'homme. Nous avons toutefois encore probablement un peu de temps avant qu'une IA prenne plaisir à lire un bon livre.

Je vous quitte avec l'info cruciale que tout le monde attend : L'entropie moyenne des phrases de ce texte est de 1.0017, entre Voltaire et Shakespear. Whahou !

Comments